Keberadaan URL dapat diperiksa dengan memeriksa kode status di header respons. Kode status 200 adalah respons Standar untuk permintaan HTTP yang berhasil dan kode status 404 berarti URL tidak ada Show

Fungsi yang Digunakan

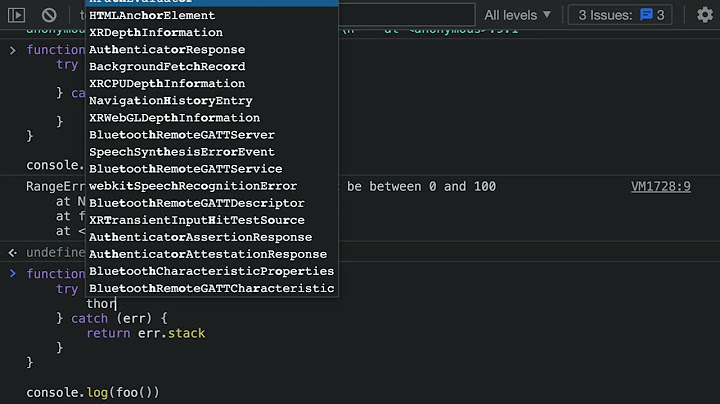

Contoh 1. Contoh ini memeriksa kode status 200 di header respons. Jika kode statusnya 200, itu menandakan URL ada sebaliknya tidak

URL Doesn't Exist_1 URL Doesn't Exist2 URL Doesn't Exist3 $urlURL Doesn't Exist5

URL Doesn't Exist_7 URL Doesn't Exist8 URL Doesn't Exist9 URL Doesn't Exist2 URL Doesn't Exist1 URL Doesn't Exist2 URL Doesn't Exist9 URL Doesn't Exist2 URL Doesn't Exist5 URL Doesn't Exist6 URL Doesn't Exist7 URL Doesn't Exist8 URL Doesn't Exist9 =<?php1;

URL Doesn't Exist8 URL Doesn't Exist9 =<?php9;

URL Doesn't Exist9 URL Doesn't Exist9 URL Doesn't Exist5

Keluaran URL Exist Contoh 2. Contoh ini memeriksa kode status 404 di header respons. Jika kode statusnya adalah 404, ini menunjukkan bahwa URL tidak ada, sebaliknya URL ada

URL Doesn't Exist_1 URL Doesn't Exist2 URL Doesn't Exist3 $urlURL Doesn't Exist5

URL Doesn't Exist_7 URL Doesn't Exist8 $url6URL Doesn't Exist2 ________62______8 URL Doesn't Exist2 URL Doesn't Exist9 URL Doesn't Exist2 URL Doesn't Exist5 =3URL Doesn't Exist7 Pustaka HTTP Salah satu fitur yang sangat berguna dari Apa itu migrasi situs?Migrasi situs adalah nama teknis yang digunakan SEO untuk merujuk pada pemetaan ulang URL dari situs lama ke situs baru, atau domain lama ke situs baru. Selama migrasi situs SEO, tim SEO Anda akan mengidentifikasi semua URL dari situs lama Anda dan URL dari situs lama Anda, lalu membuat rencana pengalihan URL sehingga siapa pun yang mengunjungi URL lama dialihkan ke yang baru, tanpa menekan 404 Kumpulan data URL dari situs lama diambil dari berbagai sumber data, termasuk perayapan situs, Google Analytics, Google Search Console, dan alat SEO seperti Ahrefs, dan tidak hanya mencakup URL saat ini di situs, yang ada di Setelah dua kumpulan data dibuat, pencocokan fuzzy (biasanya melalui Mengapa mendeteksi pengalihan selama migrasi situs?Jika Anda hanya membuat daftar semua URL lama dan memetakan masing-masing ke URL terdekat di situs baru, Anda berpotensi mengabaikan pengalihan yang ada yang mungkin telah dilakukan oleh administrator situs. Misalnya, jika produk di Hal ini dapat mengakibatkan Anda mengalihkan lalu lintas ke halaman lain menggunakan pencocokan fuzzy dan mengabaikan alternatif yang dipilih manusia. Selanjutnya, saya akan menunjukkan kepada Anda bagaimana Anda dapat menggunakan Muat paketPertama, buka notebook Jupyter dan impor paket requests untuk memeriksa setiap URLMuat datanyaSelanjutnya, muat daftar URL yang ingin Anda periksa. Saya telah menyertakan daftar sederhana di bawah ini, tetapi Anda mungkin memilikinya dalam file CSV. Jika demikian, Anda dapat mengekstrak kolom dan menyimpannya ke daftar menggunakan kode seperti ini. Ulangi URL dan periksa pengalihanSekarang kami memiliki daftar URL untuk diperiksa, kami akan membuat requests. Sebelum melakukan ini, kami akan membuat kerangka data Pandas kosong bernama Kami akan meneruskan setiap URL ke Jika objek requests berisi nilai di Saya telah mencetak setiap kamus original_urloriginal_statusdestination_urldestination_status0https. //bbc. bersama. uk/iplayer301https. // www. bbc. bersama. uk/iplayer2001https. //facebook. com/301https. // www. facebook. com/2002https. // www. penjaga. com/302https. // www. penjaga. com/uk2003https. // ilmu data praktis. bersama. uk/200 Periksa URL peta situs Anda untuk pengalihanAplikasi lain yang berguna dari teknik ini adalah untuk memeriksa URL peta situs Anda untuk pengalihan. Anda biasanya berharap salah satu halaman yang terdaftar di peta situs XML Anda tidak dialihkan ke halaman lain, jika tidak, pengguna tidak akan pernah bisa mencapai halaman yang diinginkan Cara termudah untuk melakukannya adalah melalui paket EcommerceTools saya, yang dapat Anda instal dengan memasukkan perintah berikut di terminal Anda. Dengan menjalankan fungsi Bagaimana saya memeriksa apakah responsnya 404 dengan Python?status_code == 404. print('Tidak Ditemukan. ') Dengan logika ini, jika server mengembalikan kode status 200, program Anda akan mencetak Sukses. . Jika hasilnya 404 , program Anda akan mencetak Tidak Ditemukan.

Bagaimana saya tahu jika URL dapat dijangkau dengan Python?Pendekatan. . Impor modul Lewati Url ke dalam permintaan. kepala() Jika respon. status_code == 200 lalu server aktif jika respon. status_code == 404 lalu server down Bagaimana saya tahu jika respons saya adalah 404?Jika Anda pernah ingin memeriksa apakah suatu halaman telah mengembalikan 404 karena alasan apa pun, salah satu cara termudah adalah dengan menggunakan fungsi pembantu kecil ini UrlExists() dengan . lokasi. href . Ini akan mengembalikan true jika status http adalah apa pun kecuali 404, jika tidak maka akan mengembalikan false.

Bagaimana Anda menekan URL dan mendapatkan respons dengan Python?Mengambil URL . impor urllib. permintaan dengan urllib. meminta. urlopen('http. //python. org/') sebagai tanggapan. html = tanggapan. . impor shutil impor tempfile impor urllib. permintaan dengan urllib. meminta. urlopen('http. //python. org/') sebagai respons. dengan tempfile. . impor urllib. permintaan req = urllib. meminta |

Pos Terkait

Periklanan

BERITA TERKINI

Toplist Popular

#2

#3

#4

Top 8 wenn kleinigkeiten am partner stören 2022

1 years ago#5

Top 7 hilfsmittel für behinderte im alltag 2022

1 years ago#6

#7

#8

Top 6 cafe da manha pobre 2022

1 years ago#9

#10

Periklanan

Terpopuler

Periklanan

Tentang Kami

Dukungan

Copyright © 2024 kemunculan Inc.